Quantitative soziale Normen begünstigen die Entwicklung von Kooperation

Was bedeutet es, ein guter Mensch zu sein? Wie bilden wir uns am besten eine Meinung über andere in unserer Gemeinschaft, und wie beeinflussen uns diese Meinungen in unseren Interaktionen? Das Forschungsgebiet der indirekten Reziprozität geht diese grundlegenden Fragen mathematisch an. Mit Hilfe der Spieltheorie wird erforscht, wie Menschen einen guten Ruf aufbauen und wie soziale Normen entstehen.

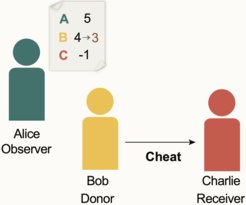

Ein Großteil der bisherigen Forschung zur indirekten Reziprozität befasst sich mit sozialen Normen, die zur Kooperation in einer Gesellschaft führen können. Es gibt acht bekannte erfolgreiche soziale Normen, die als die "führenden Acht" bezeichnet werden. Wenn Individuen diese Normen anwenden, stufen sie sich gegenseitig entweder als "gut" oder "schlecht" ein. Auf der Grundlage dieser Einstufungen entscheiden sie dann, mit wem sie kooperieren. Solche einfachen moralischen Normen können zu einer interessanten Dynamik führen. Nehmen wir ein Beispiel: Wenn Alice zunächst einen guten Ruf in ihrem Freundeskreis genießt, sich dann aber gegenüber Bob schlecht verhält, dann kann ihr Ruf darunter leiden. Auf diese Weise ändert sich der Ruf in einer Gemeinschaft im Laufe der Zeit, je nachdem, wie sich die Menschen verhalten und welche Normen sie anwenden. Wenn jeder eine der acht führenden Normen anwendet, ist die Gemeinschaft in der Regel vollständig kooperativ, da selbstsüchtiges Verhalten dem eigenen Ruf zu sehr schadet.

Viele der früheren Arbeiten gehen jedoch davon aus, dass alle relevanten Informationen über den Ruf der Einzelnen öffentlich sind. Infolgedessen sind Meinungen perfekt synchronisiert - wenn Alice Bob für gut hält, stimmen alle anderen zu. In vielen realen Szenarien haben die Menschen jedoch nur Zugang zu unvollständigen oder fehlerhaften Informationen. So kann es sein, dass sie nicht alles in ihrer Gemeinschaft beobachten können, oder dass sie einige ihrer Beobachtungen falsch interpretieren. Außerdem teilen die Menschen nicht unbedingt alle ihre Informationen oder Meinungen miteinander. Selbst wenn Alice Bob für schlecht hält, könnte Charlie das anders sehen. Sobald Informationen privat und möglicherweise fehlerhaft sind, deuten frühere Arbeiten darauf hin, dass keine der „führenden Acht“ in der Lage ist, Kooperation zu stabilisieren. Das Problem ist, dass anfängliche Meinungsverschiedenheiten sich ausbreiten können. Sobald Alice und Charlie sich über Bob uneinig sind, könnten sie beginnen, sich auch über den Ruf des jeweils anderen uneinig zu sein.

Vermeiden von Anhäufung verschiedener Meinungsbilder

Dieses Problem wird nun in einem neuen Artikel von Forschern des KAIST-Korea, des IST-Austria, und des Max-Planck-Instituts für Evolutionsbiologie in Plön behandelt. Die Forscher wollten herausfinden, wie Reputationssysteme die Anhäufung von Meinungsverschiedenheiten vermeiden können. Zu diesem Zweck untersuchten sie soziale Normen, die es Individuen erlauben, einen komplexeren Ruf zu haben als nur "gut" und "schlecht". Stattdessen verwenden Individuen numerische Punktzahlen, um den Ruf der anderen zu bemessen. So kann Alice beispielsweise einen Wert von 5 haben, während Bob einen Wert von 3 hat. Diese Werte können sich im Laufe der Zeit ändern, je nach den Interaktionen der Personen und den sozialen Normen der Gemeinschaft. Reputationen unterhalb eines bestimmten Schwellenwerts werden dann insgesamt als "schlecht" eingestuft, während Werte, die dem Schwellenwert entsprechen oder darüber liegen, als "gut" eingestuft werden. Dieses Modell führt natürlich zu einer feiner abgestuften Beschreibung der "moralischen Gutheit". Wenn Menschen diese Art von quantitativem Reputationssystem verwenden, gibt es mehr Spielraum für einzelne Fehler oder verpasste Beobachtungen. Wenn Alice beispielsweise Bob eine Punktzahl von 4 zuweist und eine seiner Handlungen falsch interpretiert, wird sie seine Punktzahl nur um 1 verringern, was dazu führt, dass sie Bob als 3 einstuft. Wenn der Schwellenwert auf die neutrale 0 gesetzt wird, bedeutet dies, dass sie Bob trotz ihres Beobachtungsfehlers immer noch als insgesamt "gut" beurteilt.

Die Forscher fanden heraus, dass solche quantitativen Bewertungen die Robustheit eines moralischen Systems drastisch erhöhen können. Tatsächlich zeigen ihre Computersimulationen, dass vier der acht führenden Normen dank quantitativer Reputationen selbst dann robust gegenüber Betrügern und blinden Altruisten sind, wenn die Entscheidungen auf unvollkommenen und verrauschten Informationen beruhen. Diese Beobachtung kann formalisiert werden. Das Team wies nach, dass Populationen, die eine dieser vier Normen annehmen, sich mit größerer Wahrscheinlichkeit von anfänglichen Unstimmigkeiten erholen, und dass diese Erholung schneller erfolgt.

Kooperative Normen jenseits der führenden Acht

"Diese Ergebnisse zeigen, wie genügend detaillierte Reputationssysteme und damit eine modifizierte Definition von 'Güte' Kooperation fördern können. Selbst unter Bedingungen, in denen schwarz-weißes 'parteiisches' Denken versagt.", erklärt die Hauptautorin Laura Schmid. "Eine Polarisierung, bei der nur angenommen wird, dass andere gut oder schlecht sind, und nichts dazwischen, kann einer Gemeinschaft erheblich schaden. Es braucht einen gewissen Puffer für Fehler." Überraschenderweise deuten diese Ergebnisse aber auch darauf hin, dass Reputationssysteme nicht zu detailliert werden sollten. Stattdessen gibt es eine optimale Skala, auf der das Verhalten bewertet werden sollte. Die Forscher stellen fest, dass dies nicht nur einige Schlüsselmerkmale natürlich vorkommender sozialer Normen erklärt, sondern auch interessante Auswirkungen auf die optimale Gestaltung künstlicher Reputationssysteme hat. "Auf diese Weise kann unsere Studie als Ausgangspunkt für künftige Herausforderungen dienen, indem wir kooperative Normen jenseits der führenden Acht erforschen", erklärt Schmid.